La calidad de los datos es fundamental en muchos aspectos, tanto en el ámbito empresarial como en la toma de decisiones en general. En la actualidad, se busca explotar las capacidades analíticas dentro de las empresas, pero muchas veces se encuentran con una gran amenaza: datos extremedamente complejos de usar. Los datos complejos de mala calidad pueden tener una variedad de problemas, como:

- Inconsistencias: Los datos pueden ser inconsistentes entre sí, lo que puede dificultar su análisis. Por ejemplo, un conjunto de datos de clientes puede tener direcciones de correo electrónico que no coinciden o fechas de nacimiento que no son coherentes.

- Incompletud: Los datos pueden estar incompletos, lo que puede limitar su utilidad. Por ejemplo, un conjunto de datos de ventas puede tener información faltante sobre los productos vendidos o los clientes que realizaron la compra.

- Errores: Los datos pueden contener errores, lo que puede sesgar los resultados del análisis. Por ejemplo, un conjunto de datos de precios puede tener precios que son incorrectos o que no están actualizados.

Algunos estudios indican que más del 80% del tiempo de los analistas de datos, incluso los científicos de datos, lo pasan realizan tareas de cleansing. Por eso es tan importante tener dataset ajustados y listos para usar, el tiempo valioso de estos recursos no puede ser mal aprovechado en tareas operativas, dado el desgaste que genera en el recurso profesional y la falta de resultados.

Algunos estudios indican que más del 80% del tiempo de los analistas de datos, incluso los científicos de datos, lo pasan realizan tareas de cleansing. Por eso es tan importante tener dataset ajustados y listos para usar, el tiempo valioso de estos recursos no puede ser mal aprovechado en tareas operativas, dado el desgaste que genera en el recurso profesional y la falta de resultados.

Aquí hay 5 pasos para garantizar la calidad de datos en la era del Big Data:

- Definir los requisitos de calidad de datos. El primer paso es definir los requisitos de calidad de datos que son importantes para la organización. Estos requisitos pueden variar según el tipo de datos, el uso previsto de los datos y los objetivos de la organización.

- Implementar procesos de control de calidad. Una vez que se hayan definido los requisitos de calidad de datos, es necesario implementar procesos para garantizar que se cumplan. Estos procesos pueden incluir la limpieza de datos, la validación de datos y la supervisión de datos.

- Automatizar las tareas de calidad de datos. La automatización de las tareas de calidad de datos puede ayudar a mejorar la eficiencia y la precisión. Hay muchas herramientas y soluciones disponibles para automatizar las tareas de calidad de datos.

- Educar a los empleados sobre la calidad de datos. Todos los empleados que trabajan con datos deben comprender la importancia de la calidad de datos. La educación sobre la calidad de datos puede ayudar a los empleados a identificar y corregir los problemas de calidad de datos.

- Crear una cultura de calidad de datos. La calidad de datos debe ser una prioridad para toda la organización. La creación de una cultura de calidad de datos puede ayudar a garantizar que la calidad de datos sea una parte integral de las operaciones de la organización.

Estos pasos son importantes para garantizar que los datos sean precisos, completos y coherentes. Los datos de alta calidad son esenciales para tomar decisiones informadas y obtener resultados empresariales positivos.

Aquí hay algunos consejos adicionales para garantizar la calidad de datos en la era del Big Data:

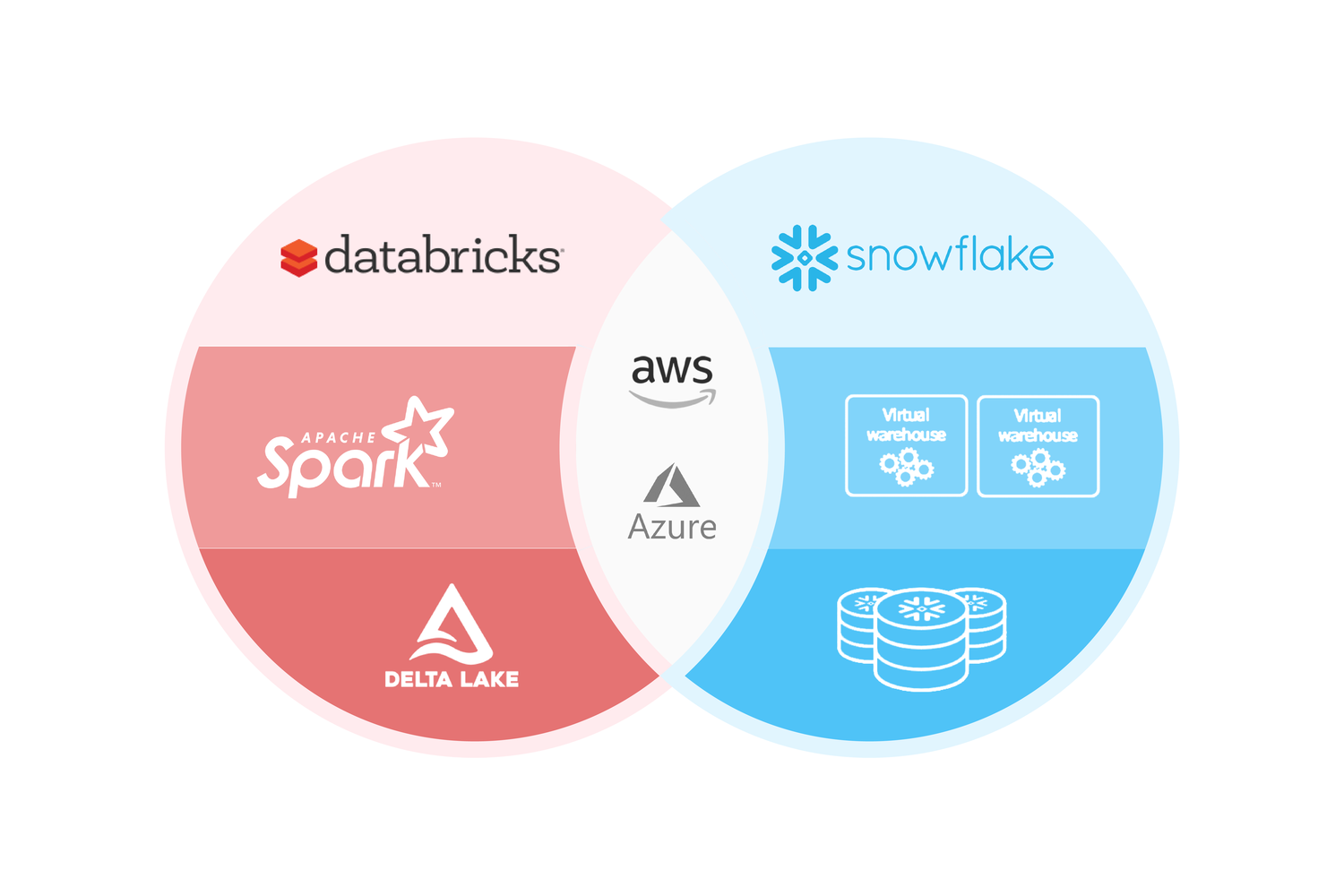

- Utilizar una plataforma de gestión de datos. Una plataforma de gestión de datos puede ayudar a organizar, almacenar y gestionar los datos de manera eficiente. Esto puede facilitar la identificación y corrección de los problemas de calidad de datos.

- Integrar la calidad de datos en el ciclo de vida de los datos. La calidad de datos debe ser una consideración desde el principio del ciclo de vida de los datos. Esto ayudará a garantizar que los datos sean de alta calidad desde el principio.

- Utilizar herramientas y soluciones de calidad de datos. Hay muchas herramientas y soluciones disponibles para ayudar a garantizar la calidad de datos. Estas herramientas pueden ayudar a automatizar las tareas de calidad de datos y a identificar y corregir los problemas de calidad de datos.

Si tu organización no tiene políticas de calidad de datos, es hora de empezar a trabajar en ellas. Hay muchas herramientas y recursos disponibles para ayudarte a crear políticas que sean efectivas.

Una vez que hayas establecido tus políticas de calidad de datos, es importante implementarlas y hacerlas cumplir. Esto ayudará a garantizar que tus datos sean de alta calidad y que puedas aprovechar el poder de los datos para impulsar tu negocio.