Resumen ejecutivo

Alcanzar el objetivo de desarrollo sostenible de la ONU de un “mundo con hambre cero” para 2030 requerirá ser más productivo, eficiente, sostenible, inclusivo, transparente y resiliente. Este objetivo requiere una transformación urgente del sistema actual de agricultura, ganadería y alimentación en general.

La Industria 4.0 está transformado muchas industrias con tecnologías disruptivas como #Blockchain, Internet de las Cosas, Inteligencia Artificial. En el sector agrícola y alimentario #SmartAgro, la difusión de tecnologías móviles, #BigData, #IoT y #Edge computing, ya están mejorando el acceso de los pequeños productores a desarrollos innovadores que les mejora su operatoria.

En #54cuatro estamos convencidos que el gran desafío de empresas como la nuestra es lograr democratizar el acceso a estas tecnologías que hasta hace poco eran exclusividad de grandes corporaciones.

En el mundo existen distintas soluciones que permiten monitorear todo tipo de elementos y por supuesto, animales. Se pueden monitorear animales de todos los tipos, desde vacas, toros, ovejas, caballos, inclusive animales salvajes o de agua.

Así como existe la comunicación entre equipos industriales de tipo #M2M (machine to machine), asumimos este desafío de armar un sistema de comunicaciones que denominamos #A2M (Animal to Machine).

Nuestra metodología a diferencia de productos standard, implica un desarrollo a medida teniendo en cuenta problemáticas puntuales.

En esta nota vamos a desarrollar el enfoque utilizado para el proyecto de Monitoreo de Búfalos en la provincia de Chaco, República Argentina.

Problemática

La situación que encontramos tiene que ver con perdidas económicas de unos USD 300.000 debido a la falla en la localización de los animales y la falla en la detección de celo, lo que generaba que las Bufalas no fuesen preñadas. La complejidad adicional provenía del hecho que el campo es de 6.000 hectáreas.

Análisis

Monitorear en granjas pequeñas y delimitadas es simple, pero ante tanto terreno tuvimos que cambiar el enfoque del proyecto. Lo primero que hicimos fue investigar el comportamiento del bubalino. Gracias a distintas entidades como el International Buffalo Federation, detectamos los siguientes patrones:

•El bubalino tiene 150 glándulas sudoríparas por cm2 a diferencia de la vaca que tiene 1500. Esto hace que necesite si o si del agua para enfriarse. Esta informacion nos sirve para detectar zonas de ubicación frecuente basados en la temperatura.

•Vive en promedio 25 años a diferencia de la vaca que vive 10, y puede dar 16 crías contra 6 que da la vaca. Esto nos marca la importancia de ubicar a las hembras para evitar perder de ciclos de celo.

•Cuando la Búfala esta en celo se deja perseguir por el macho o lo deja que se apoye sobre la grupa. Podemos detectar síntomas de celo teniendo en cuenta el comportamiento de sus movimientos.

•El animal enfermo o con riesgo de muerte, se aleja del grupo. Esto es importante para controlar la causa de mortandad y recuperar los sensores.

Diseño de Solución

Con esos patrones comenzamos a diseñar 3 cosas. Por un lado la cobertura de red para detectar la posición del animal. En segundo lugar el tipo de sensor, dado que por como se comporta el animal, no podíamos usar un sensor común porque no aguantaría tanto tiempo sumergido, porque el animal se lo rozaría contra arboles para quitárselo, etc. Y por otro lado, patrones de reportes que nos permitan detectar ubicación, posibles condiciones de celo, enfermedad, etc.

Diseñamos el sensor basados en el comportamiento. Lo que hicimos fue probar diseños sobre modelos 3D.

Para la conectividad instalamos:

• 3 Mástiles de comunicaciones a 3 vientos completos de 36 Metros de alto, estrella antirotor, baliza. Obra civil: anclajes elevados, cerco de protección de campo con puertas, y ahi montamos 3 Gateways LoRa.

• Radioenlaces para transporte IP Ubiquiti y Routers Mikrotik PoE en Gabinetes de exterior de 10U, Autónomos mediante Energía solar (paneles y baterías de 100ah).

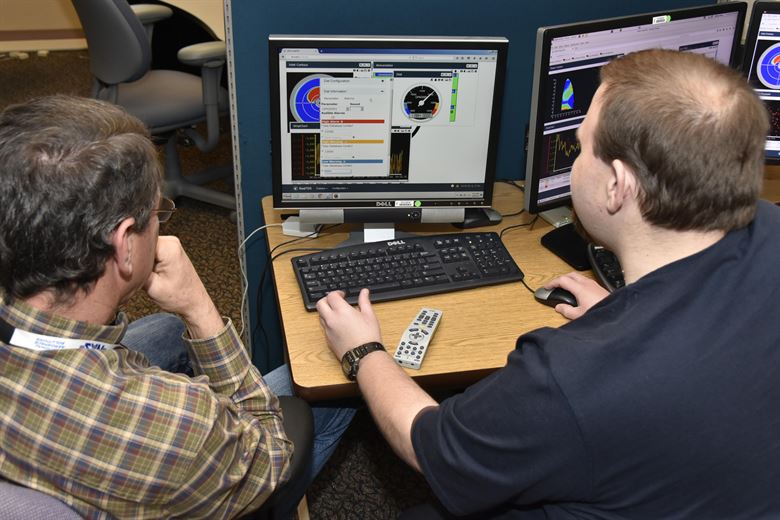

Cada animal se transformo en un nodo de trasmision. Usamos la plataforma de geolocalización desarrollada por Odea para determinar el posicionamiento y cruzar los datos del #GPS con los datos del Ear Tag que contiene:

- UID Stick

- ID Posicionamiento

- Nombre

- Genero

- Fecha Nacimiento

- Posición

- Estado Servicio

- Vacunación

- Peso

Adicionalmente incorporamos otros tipos de Datapoints que eran de nuestro interés, como por ejemplo factores climáticos y cronogramas de sanidad.

Finalmente para reducir los tiempos de detección del estado del animal, adoptamos un dron dotado con plan de vuelo, plan de vuelo multiespectral, y con un gran rango visual, gracias a la gente de Runco quienes nos ayudaron a encontrar el mejor equipo para lo que necesitábamos.

Resultados

Con la implementación de nuestra solución, la plataforma se estará dotando de insights provenientes de cada nodo, lo que nutrirá nuestros catálogos de datos y nos permitirán ir ajustando algoritmos de detección de patrones. Esos patrones detectados deben posibilitar algunos resultados claves:

- Encontrar a cada animal

- Detectar señales de celo

- Entender el comportamiento según temperatura, humedad, lluvias, etc.

- Optimizar el control del peso de cada animal y la alimentación en base a los controles.

- Disminuir riesgos y mortandad

| [popup_anything id=”2076″] |