A menudo nos preguntan cómo aseguramos la calidad de los datos en los #DataLakehouses. En este artículo, exploraremos la necesidad de validar los datos, qué datos deben validarse y cómo hacerlo. Estos son aspectos con los que muchas empresas lidian al iniciar su viaje hacia los Data Lakehouses.

¿Por qué es importante la calidad de los datos?

La #calidad de los datos es crucial. La falta de validación puede tener numerosos efectos operativos y estratégicos para cualquier organización, desde decisiones incorrectas hasta pérdida de ingresos y daño a la reputación. En áreas altamente reguladas, una mala calidad de datos puede tener consecuencias legales y financieras.

Marco de calidad y gobernanza de datos

Antes de implementar soluciones, es esencial definir un marco de calidad y #gobernanza de datos que contemple desde la estrategia de la organización hasta los acuerdos sobre el procesamiento de la calidad de los datos.

En 54cuatro hacemos mucho énfasis en la importancia de una adecuada gobernanza de datos.

Gestión Intrusiva vs. No Intrusiva de la Calidad de Datos

Al validar los datos, puedes optar por no interrumpir los flujos de datos (no intrusiva) o detenerlos si se detectan problemas (intrusiva), dependiendo de las tolerancias a errores y las potenciales demoras que esto pueda causar.

Gestión de la Calidad de Datos en la Fuente o en la Arquitectura Lakehouse

La gestión de la calidad de los datos puede realizarse tanto en la fuente como en la arquitectura Lakehouse. Cada enfoque tiene sus ventajas, desde la detección temprana de errores hasta la adaptación flexible a los cambios en los requisitos de calidad de los datos.

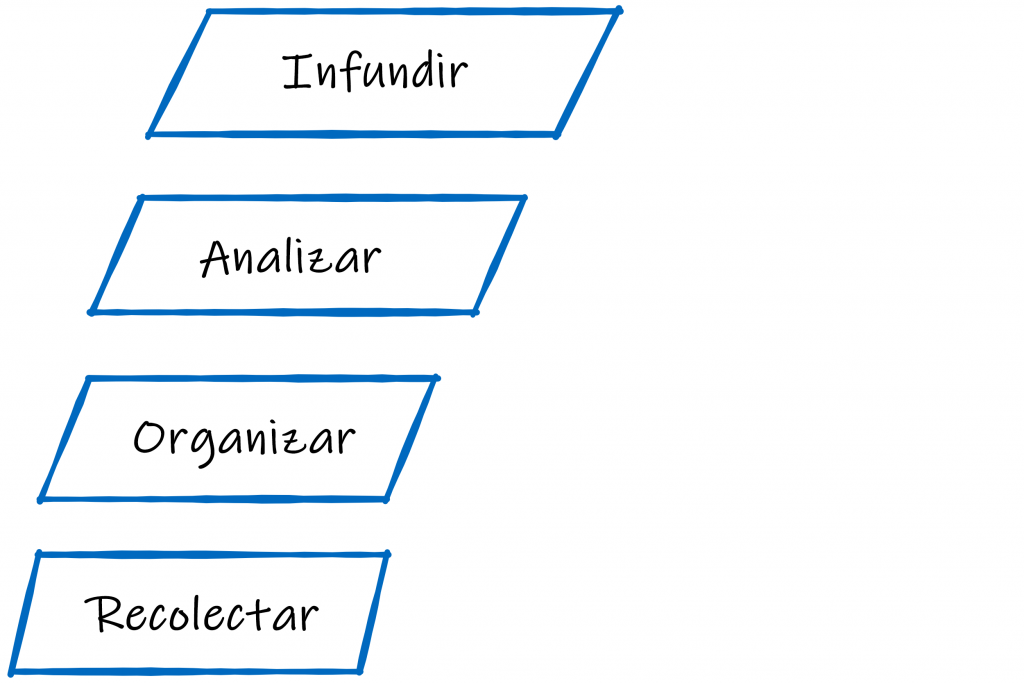

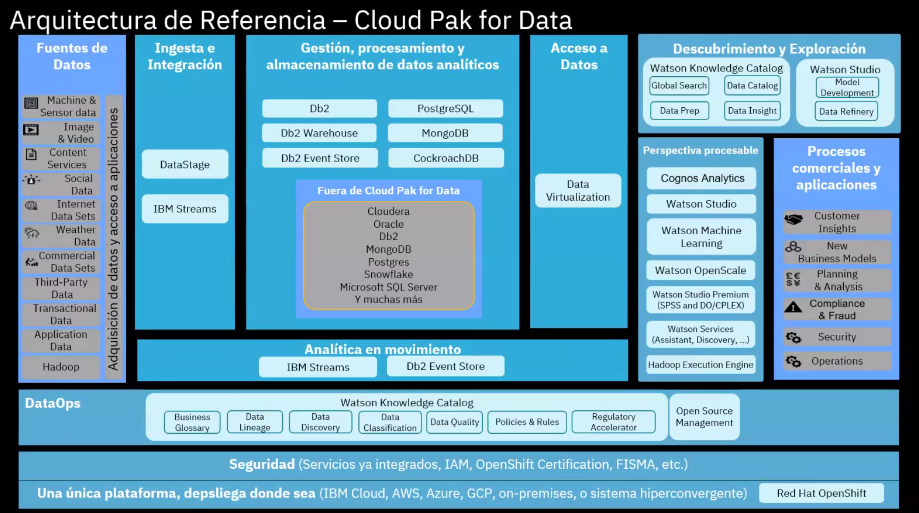

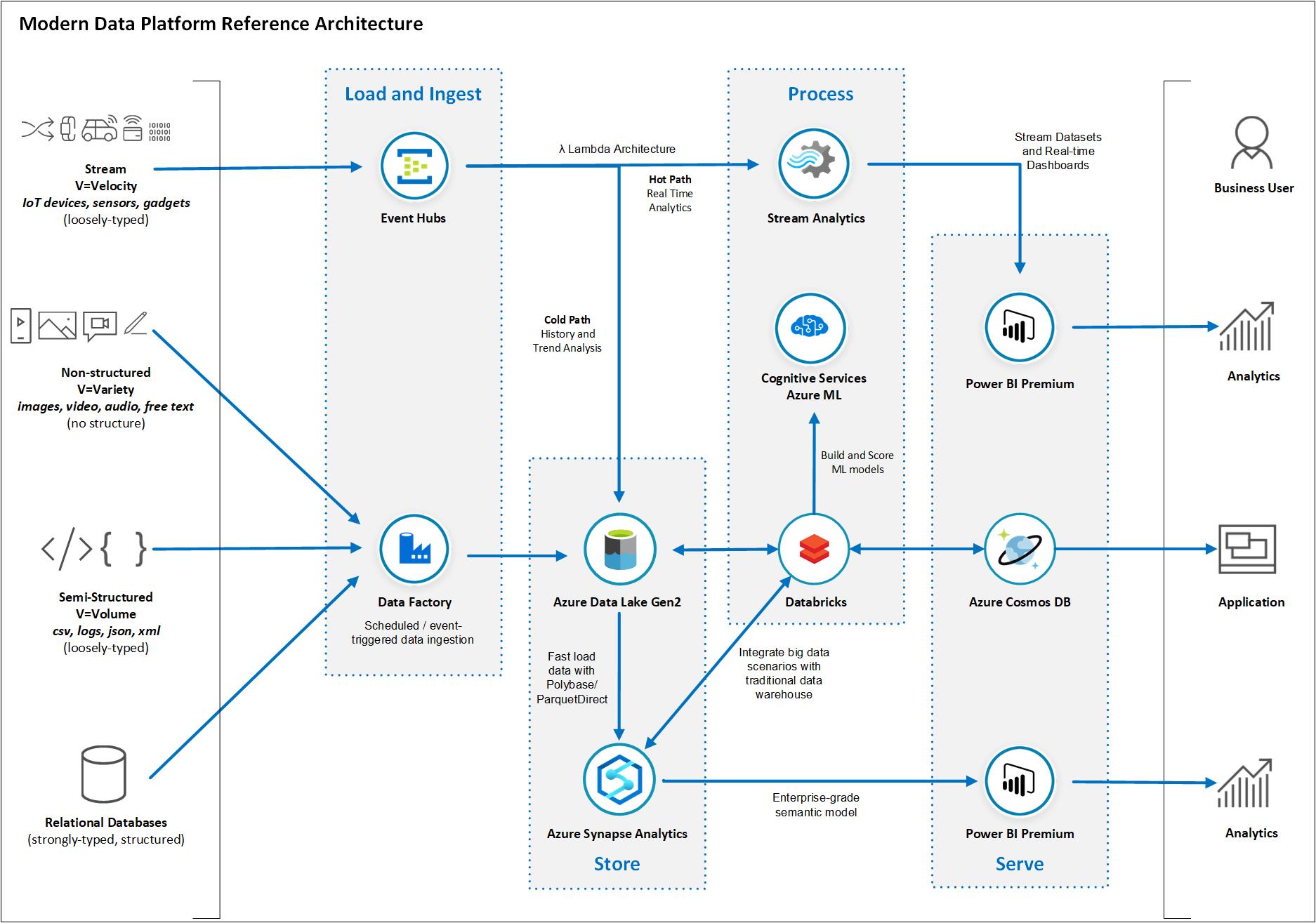

Diseño Común de Lakehouse

El patrón de arquitectura que siguen los data lakehouses se llama Arquitectura Medallion, combinan las capacidades de los data lakes y los data warehouses, estructurados típicamente en capas (bronce, plata, oro) con controles de calidad de datos en cada una para asegurar la organización y optimización de los datos.

Capa de Bronce: Almacena datos brutos, enfocándose en la completitud, consistencia y precisión.

Capa de Plata: Contiene datos procesados, con énfasis en la precisión y la consistencia. Este es un buen stage para practicar la calidad.

Capa de Oro: Guarda datos de la más alta calidad, concentrándose en la precisión, consistencia, completitud y oportunidad.

Consideraciones Tecnológicas

Para la validación inicial de datos, tecnologías como Autoloader en Databricks y marcos personalizados en Synapse son útiles. Para capas posteriores, herramientas como DLT, DBT y Great Expectations ofrecen integración, automatización y flexibilidad en la gestión de la calidad de los datos.

Conclusión:

La calidad de los datos es un proceso continuo que requiere monitoreo, validación y actualización regulares. Elegir una tecnología que se adapte y escale con tu organización es clave para proporcionar datos de calidad consistentemente y apoyar la toma de decisiones informada y el crecimiento del negocio.